فایل Robots.txt چیست؟

فایل Robot.txt، یک فایل متنی است که وظیفه دارد خزش و ایندکس کردن رباتهای گوگل و موتورهای جستجوی را هدفمندتر کند. به طور مثال، این فایل به موتورهای جستجو میگوید کدام صفحات را نباید ایندکس کنند. به همین خاطر تمامی رباتها در موتورهای جستجوگر، قبل از اینکه به هر سایتی وارد شوند، ابتدا فایل Robots.txt را مورد بررسی قرار میدهند و بر اساس آن، نسبت به ایندکس کردن صفحات اقدام میکنند. این فایل در بالاترین سطح و در ریشه سایت قرار میگیرد، به طوری که اگر پس از آدرس URL سایت عبارت Robots.txt را تایپ کنید، محتویات داخل آن برای شما نمایش داده میشود.

اهمیت و ضرورت استفاده از فایل Robots.txt

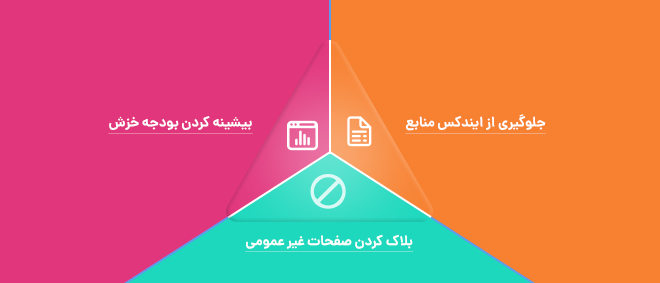

در حقیقت این فایل به شما کمک میکند تا صفحات سایت خود را فقط برای کاربران طراحی کنید و ترس از محتوای تکراری، وجود لینک های زیاد در آن و تاثیر منفی سئو نداشته باشید. فایل Robots.txt به شما این امکان را میدهد تا صفحاتی که ارزش زیادی ندارند را از دید رباتهای موتورهای جستجو مخفی کنید تا زمان آنها در بررسی و ایندکس کردن صفحات سایت شما به هدر نرود. در ادامه به صورت تخصصی دلایل استفاده از این فایل را بیان میکنیم:

-

بلاک کردن صفحات غیر عمومی

در برخی مواقع ممکن است شما صفحاتی در سایت خود داشته باشید که نمیخواهید در موتورهای جستجو ایندکس شود. مثلا ممکن است برای یک صفحه، نسخه آزمایشی ایجاد کرده باشید و نمیخواهید کاربران به صورت تصادفی به آن دسترسی داشته باشند. در این حالت میتوانید با استفاده از فایل Robots.txt، صفحه مورد نظر را برای رباتهای جستجو و کراولرها بلاک کنید.

-

بیشینه کردن بودجه خزش

چنانچه برای ایندکس کردن صفحات سایت خود به مشکل برخورد کردید، به احتمال زیاد این مشکل برآمده از بودجه خزش (به انگلیسی: Crawl Budget) میباشد. شما با استفاده از Robots.txt و بلاککردن صفحات کمارزش برای موتورهای جستجو، میتوانید نرخ خزش بیشتری برای صفحات مهمتر داشته باشید.

-

جلوگیری از ایندکس منابع

متاتگ ها یا Meta Directiveها گاهی اوقات میتوانند مانند فایل Robots.txt بکارگیری شوند و از ایندکس شدن بعضی صفحات جلوگیری کنند. البته دقت داشته باشید که متاتگ ها برای منابع چند رسانه ای مانند عکس و پی دی اف به خوبی کار نمیکنند.

به طور کلی می توان گفت مسئولیت اصلیِ Robots.txt سایت جلوگیری از ایندکس برخی صفحات توسط رباتها و کراولرهای گوگل میباشد. برای اینکه متوجه شوید چه تعداد از صفحات سایت شما ایندکس شده اند، می توانید از سرچ کنسولِ گوگل استفاده کنید. اگر تعداد صفحاتی که ایندکس شده است، با همان تعدادی که خودتان در نظر داشتید همخوانی دارد، نیازی نیست از فایل Robots.txt استفاده کنید. اما اگر تعداد صفحاتی که ایندکس شده است بیشتر از تعداد مدنظر شماست، بهتر است از این فایل استفاده کنید.

نحوه استفاده از فایل Robots.txt سایت

به طور کلی فایل robots.txt از انعطافپذیری زیادی برخوردار است. همانطور که گفته شد، این فایل به متخصصان سئو کمک میکند تا به طور همزمان و بدون نوشتن کد خاصی از ایندکسشدن چندین صفحه جلوگیری کنند. در ادامه دستورات و نحوه استفاده و این فایل را توضیح می دهیم.

-

User-agent

در ابتدای این فایل متنی و قبل از نوشتن هر دستوری، باید از عبارت User-agent استفاده کنید. این دستور نشان دهنده این است که هدف شما دقیقا کدام ربات خزنده است. نحوه استفاده از این عبارت بدین شکل است که بعد نوشتن عبارت یک دو نقطه در مقابل آن قرار می دهید، سپس نام ربات مورد نظر را می نویسید. برای مثال دستور User-agent: googlebot به ربات گوگل دستور میدهد.

نکته: دقت داشته باشید، چنانچه بخواهید تمامی رباتهای خزنده وب را مورد هدف قرار دهید، باید یک کاراکتر * در مقابل User-agent: بگذارید. (User-agent: *)

-

دستور Disallow و Allow

پس از اینکه ربات هدف خود را مشخص کردید، با استفاده از این دستورات می توانید برای رباتها مشخص کنید که اجازه خزش و ایندکس کردن کدام صفحات را دارند یا ندارند. برای اینکه به رباتها اجازه دهید صفحات را ایندکس کنند، از دستور Allow و برای پیشگیری از ایندکس کردن از دستور Disallow باید استفاده کنید.

پس از اینکه دستور مورد نظر را نوشتید و یک دو نقطه در مقابل آن قرار دادید (برای مثال Allow:) باید صفحه یا صفحاتی که قصد دارید دستورات روی آن اعمال شود را بنویسید. برای اینکار لازم نیست تمام آدرس URL صفحه را قرار دهید. کافیست از قسمت / به بعد وارد کنید و قسمت دامنه را وارد نکنید. برای مثال اگر قسمت ادمین سایت شما با پارامتر admin در URL مشخص شده است (www.example.com/admin) می توانید به شکل زیر از این دستورات استفاده کنید.

User-agent: *

Disallow: /admin/

دقت داشته باشید، صفحاتی که در فایل robots.txt سایت تان از ایندکسشدن آن ها جلوگیری میکنید را در سایت مپ قرار ندهید.

قرار دادن فایل Robots.txt در سرچ کنسول

پس از اینکه فایل مورد نظر را ایجاد کردید و در سایت خود قرار دادید، باید در سرچ کنسولِ گوگل هم تغییرات لازم را اعمال کنید. برای این کار کافیست بخش robots.txt tester را در سرچ کنسول نسخه قدیمی پیدا کنید، اما اگر موفق به انجام اینکار نشدید، میتوانید همین عبارت را در موتور جستجوی گوگل سرچ کنید تا وارد این بخش شوید.

در قسمتی از آن به شما اجازه داده میشود متن داخل robots.txt را در سرچ کنسول قرار دهید تا گوگل راحتتر دستورات شما را ببیند. همچنین در قسمت تست میتوانید URLهای مد نظر خود را قرار دهید تا متوجه شوید کدام یک از آنها برای رباتهای گوگل Disallow شدهاند.

جمع بندی

فایل robots.txt یکی از حساسترین موارد در سئو سایت می باشد، بر همین اساس توصیه میکنیم در نوشتن دستورات آن دقت زیادی داشته باشید. اگر به اشتباه صفحات اصلی سایت خود را برای موتورهای جستجو Disallow کنید، احتمال دارد تمام سئو شما با مشکل مواجه شود و رتبههای خود را از دست بدهید. بنابراین قطعا بر اساس توضیحات این مقاله آموزشی فایل Robot.txt را بهینه کنید.

نظر خود را بگذارید